„Max Mustermann ist oft krank, meist eher passiv, die Performance mäßig, aber wenn die KI halluziniert, wird er zum Löwen“

Warum wir Menschen mehr Fehler machen als Maschinen – und warum das trotzdem okay ist

Stell dir Max Mustermann vor: In Meetings eher stumm, beim Flurfunk desto lauter. Oft nicht da, wenn es darauf ankommt und auch sonst eher wenig um Rat gefragt aber wehe, die KI macht einen Fehler, dann wird Max offiziell empört. Klingt vertraut? Willkommen im Alltag zwischen menschlicher Fehlbarkeit und künstlicher Intelligenz.

Die nackten Zahlen: Mensch vs. KI

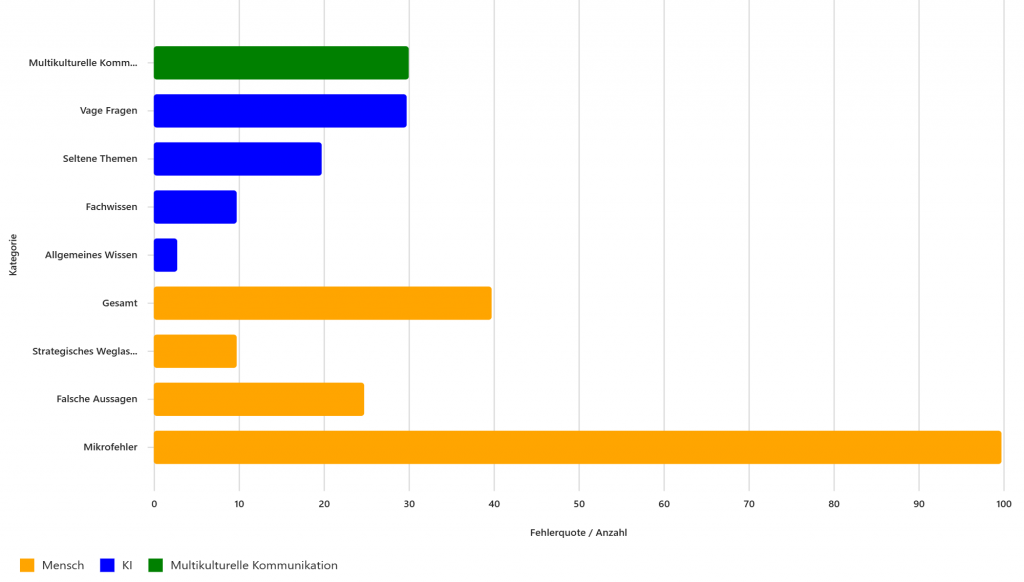

Menschliche Fehlerquote pro Arbeitstag:

- Mikrofehler: 20–100 kleine Patzer (Wahrnehmung, Erinnerung, Interpretation).

Meist harmlos: übersehen, missverstanden, falsch erinnert. - Falsche Aussagen: 5–25 pro Tag – nicht gelogen, nur falsch.

Gründe? Stress, Ablenkung, schlechte Infos. - Strategisches Weglassen: 1–10 Mal täglich.

Nicht böse gemeint – eher „keine Zeit für Details“ oder „Konflikte vermeiden“.

Kurz gesagt: Ein normaler Mensch liegt 10–40 % der Zeit daneben, ohne es zu merken.

KI-Fehlerquote (Halluzinationen):

- Allgemeines Wissen: 1–3 %

- Fachwissen: 3–10 %

- Seltene Themen: 10–20 %

- Vage Fragen: bis zu 30 %

Kurz gesagt: Moderne KI liegt meist richtig – aber ihre Fehler sind spektakulär sichtbar.

Der direkte Vergleich

Ein Mensch macht 5–20× mehr Denk- oder Aussagefehler als eine KI bei gleicher Anzahl Aussagen.

Das bedeutet: Wir irren oft, die KI selten – aber wenn sie irrt, dann mit voller Überzeugung.

Unternehmen im internationalen Umfeld sind besonders betroffen

Multikulturelle Kommunikation & Sprachbarrieren

Wenn Menschen aus unterschiedlichen Kulturen in einer gemeinsamen Geschäftssprache (oft Englisch) kommunizieren – und viele sind Non-Native Speaker – steigt die Fehlerquote deutlich. Warum?

- Sprachliche Unsicherheit: Missverständnisse durch Wortwahl, Grammatik oder fehlende Nuancen.

- Kulturelle Höflichkeit: Manche Kulturen vermeiden direkte Kritik oder klare Aussagen → strategisches Weglassen steigt.

- Interpretationsfehler: Gestik, Tonfall und „zwischen den Zeilen“ lesen funktioniert kulturübergreifend oft nicht.

- Stressfaktor: Wer in einer Fremdsprache denkt, braucht mehr kognitive Ressourcen → höhere Mikrofehler.

Schätzung:

In internationalen Teams kann die menschliche Fehlerquote noch einmal um 20–30 % steigen, vor allem bei komplexen Themen oder schnellen Entscheidungen.

Was heißt das für uns im Business?

- Menschen sind nicht perfekt – und das ist okay. Fehler gehören zum Alltag.

- KI ist kein Orakel. Sie ist gut, aber nicht unfehlbar.

- Die Kunst liegt im Zusammenspiel: Menschliche Intuition + maschinelle Präzision = weniger Fehler, mehr Erfolg.

Fazit:

Vielleicht sollten wir Max beim nächsten KI-Fehler daran erinnern: Auch wir liegen oft daneben,nur merkt es keiner so schnell.

Genau aus diesem Grund sollten wir es in Zukunft anstreben, eine Art „Wissens-Symbiose“ zusammen mit der KI zu generieren. Eine ständige Überprüfung der Ergebnisse und Verifizierung, von beiden Seiten.

=> Hier geht es zum Teil 2 und Fortsetzung dieses Artikels, der sich mit dem Umgang der KI beschäftigt

Quellenverzeichnis

1. Human Error & Human Factors

Reason, James.

Human Error. Cambridge University Press, 1990.

Grundlegendes Werk zur systematischen Analyse menschlicher Fehlerraten und Ursachen.

Reason, James.

The Human Contribution: Unsafe Acts, Accidents and Heroic Recoveries. CRC Press, 2008.

Vertiefung des „Swiss Cheese Model“ und menschlicher Fehlerquellen in Organisationen.

Hollnagel, Erik.

Human Reliability Analysis: Context and Control. Academic Press, 1993.

Belastbares Werk zur Zuverlässigkeit von Menschen in komplexen Arbeitsumfeldern.

Wiegmann, Douglas & Shappell, Scott.

Human Error in Aviation. Routledge, 2017 (2. Auflage).

Zeigt gut dokumentierte Fehlerquoten im Cockpit und in sicherheitskritischen Bereichen.

2. Kognitive Verzerrungen & Denkfehler

Kahneman, Daniel.

Thinking, Fast and Slow. Farrar, Straus and Giroux, 2011.

Übersicht über Heuristiken, Biases und systematische Denkfehler.

Tversky, Amos & Kahneman, Daniel.

„Judgment under Uncertainty: Heuristics and Biases.“

Science, Vol. 185, 1974, S. 1124–1131.

Bahnbrechende Originalarbeit, die bis heute zitiert wird.

Ariely, Dan.

Predictably Irrational. HarperCollins, 2008.

Populärwissenschaftlich, aber wissenschaftlich fundiert über systematische Fehlentscheidungen.

3. Fehler im medizinischen und industriellen Kontext

Kohn, Linda et al. (Institute of Medicine).

To Err Is Human: Building a Safer Health System. National Academies Press, 1999.

Begründet die moderne Fehlerforschung in der Medizin; zeigt hohe Fehlerquoten.

Leape, Lucian.

„Error in Medicine.“

JAMA, 1994.

Klassische Arbeit über diagnostische und organisatorische Fehlerstrukturen.

Reason, James & Hobbs, Alan.

Managing Maintenance Error. Ashgate, 2003.

Fehleranalyse im technischen und industriellen Umfeld.

4. Organisationspsychologie & Kommunikation

Edmondson, Amy C.

The Fearless Organization. Wiley, 2018.

Grundlage der psychologischen Sicherheit; erklärt, warum Menschen Informationen zurückhalten.

Morrison, Elizabeth & Milliken, Frances.

„Organizational Silence: A Barrier to Change and Development in a Pluralistic World.“

Academy of Management Review, 2000.

Eine der Kernarbeiten über bewusstes Schweigen im Arbeitskontext.

Tedeschi, James & Riess, Marlin.

„Impression Management and the Self.“

Psychological Perspectives on the Self, 1981.

Zeigt, wie Menschen Informationen bewusst filtern, um sich sozial zu schützen.

5. KI-Halluzinationen, Faktenfehler & Benchmarks

Lin, Stephanie et al. (Stanford).

„TruthfulQA: Measuring How Models Imitate Human Falsehoods.“

arXiv:2109.07958, 2021.

Benchmark zur Messung von Halluzinationsraten großer Sprachmodelle.

Kadavath, Saurav et al. (OpenAI).

„Language Models Show Human-Like Content Preferences.“

arXiv, 2022.

Beinhaltet Evaluationsmethoden zur Beurteilung faktischer Korrektheit.

Meta AI Research.

„LLaMA Model Card & Evaluation Results.“

Meta Research Reports, 2023–2024.

Dokumentiert Fehler- und Halluzinationsraten verschiedener LLMs.

OpenAI Technical Reports (GPT-4, GPT-4.1, GPT-4.1-preview, GPT-5 Series).

OpenAI, 2023–2025.

Enthält transparente Angaben zu Modellverhalten und Halluzinationshäufigkeit in Benchmarks.

6. Ergänzende Literatur zur menschlichen Fehlerrate

Norman, Donald A.

The Design of Everyday Things. MIT Press, 2013.

Zeigt systematische menschliche Fehlertendenzen im Alltag und bei Bedienhandlungen.

Helmreich, Robert & Merritt, Ashleigh.

Culture at Work in Aviation and Medicine. Routledge, 1998.

Untersucht kulturell bedingte Fehlerquoten in Hochrisikobranchen.